- 开源吧 > JAVA开源项目 > 其它 > ObjectWeb项目

Apache Chemistry

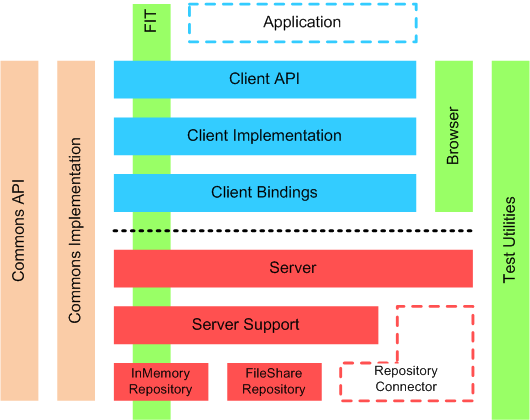

Apache Chemistry是Content Management Interoperability Services (CMIS) 规范的一个开源实现。该项目当前由以下子项目组成:

OpenCMIS - CMIS Java客户端和服务器端类库

cmislib - CMIS Python客户端类库

phpclient - CMIS PHP客户端类库

DotCMIS - CMIS .NET客户端类库

网友留言/评论

我要留言/评论

相关开源项目

Commons Compress: Commons Compress提供了一组API用于操作(解压/压缩)ar、cpio、tar、zip、gzip和bzip2等格式的文件。ZipArchiveEntry entry = new ZipArchiveEntry(name);entry.setSize(size);zipOutput.putArchiveEntry(entry);zipOutput.write(contentOfEntry);zipOutput.closeArchiveEntry();

Apache SSHD: Apache SSHD是一个100%纯Java类库用于在基于Java开发的客户端与服务器提供SSH协议支持。这个类库采用Apache MINA开发,它是一个可扩展和高性能的异步IO类库。

JavaService:JavaService是一个WIN32可执行程序(EXE)利用它可以把任何Java Class制作成一个NT Service来运行。

Apache Compress Ant Library: Apache Compress Ant Library提供了一些Tasks和Types来读写各种类型的压缩文件和存档文件。支持AR、BZIP2、CPIO、GZIP、TAR和ZIP格式。

数据序列化框架Apache Avro: Avro是Hadoop中的一个子项目,也是Apache中一个独立的项目,Avro是一个基于二进制数据传输高性能的中间件。在Hadoop的其他项目中例如HBase和Hive的Client端与服务端的数据传输也采用了这个工具,Avro可以做到将数据进行序列化,适用于远程或本地大批量数据交互。在传输的过程中Avro对数据二进制序列化后 节约数据存储空间 和 网络传输带宽。Avro还可以做到在同一系统中支持多种不同语言,也有点类似Apache的另一个产品:Thrift,对于Thrift不同的是Avro更加具有灵活性,Avro可以支持对定义的数据结构(Schema)动态加载,利于系统扩展。摘自: Avro入门1–序列化与远程通信

Apache Pig: Pig是一个基于Hadoop的大规模数据分析平台,它提供的SQL-LIKE语言叫Pig Latin,该语言的编译器会把类SQL的数据分析请求转换为一系列经过优化处理的MapReduce运算。Pig为复杂的海量数据并行计算提供了一个简单的操作和编程接口。

Pig的实现有5个主要的部分构成:如图所示:

1.Pig自己实现的一套框架对输入、输出的人机交互部分的实现,就是Pig Latin 。2.Zebra是Pig与HDFS/Hadoop的中间层、Zebra是MapReduce作业编写的客户端,Zerbra用结构化的语言实现了对hadoop物理存储元数据的管理也是对Hadoop的数据抽象层,在Zebra中有2个核心的类 TableStore(写)/TableLoad(读)对Hadoop上的数据进行操作。3.Pig中的Streaming主要分为4个组件: 1. Pig Latin 2. 逻辑层(Logical Layer) 3. 物理层(Physical Layer) 4. Streaming具体实现(Implementation),Streaming会创建一个Map/Reduce作业,并把它发送给合适的集群,同时监视这个作业的在集群环境中的整个执行过程。 4.MapReduce在每台机器上进行分布式计算的框架(算法)。5.HDFS最终存储数据的部分。

Pig的实现有5个主要的部分构成:如图所示:

1.Pig自己实现的一套框架对输入、输出的人机交互部分的实现,就是Pig Latin 。2.Zebra是Pig与HDFS/Hadoop的中间层、Zebra是MapReduce作业编写的客户端,Zerbra用结构化的语言实现了对hadoop物理存储元数据的管理也是对Hadoop的数据抽象层,在Zebra中有2个核心的类 TableStore(写)/TableLoad(读)对Hadoop上的数据进行操作。3.Pig中的Streaming主要分为4个组件: 1. Pig Latin 2. 逻辑层(Logical Layer) 3. 物理层(Physical Layer) 4. Streaming具体实现(Implementation),Streaming会创建一个Map/Reduce作业,并把它发送给合适的集群,同时监视这个作业的在集群环境中的整个执行过程。 4.MapReduce在每台机器上进行分布式计算的框架(算法)。5.HDFS最终存储数据的部分。

Enhydra Octopus:Octopus是一个基于Java的ETL工具(数据抽取:Extract、转换:Transform、装载:Load)。它可以连接任何JDBC数据源并通一个XML文件完成数据转换。一个loadjob生成器提供从现存的数据库中生成Octopus loadjob构架.多种不同的数据可以被混合在一起(MSSQL, Oracle, DB2, QED, JDBC-ODBC with Excel and Access, MySQL, CSV-files, XML-files,..) Octopus自带三个特殊的JDBC驱动用来支持通过JDBC访问CSV-files (CSV-JDBC), MS-SQL (FreeTDS)和XML. Octopus支持用Ant和Junit创一个数据库/表并能在构建或测试过程中可以抽取/装载数据.

Apache Tika: Apache Tika是一个Java工具包用于利用现有的解析类库,从不同格式的文档中(例如HTML,PDF,Doc),检测和提取出元数据和结构化内容。 功能包括: 1.检测文档的类型,字符编码,语言,等其他现有文档的属性。2.提取结构化的文字内容。3.该项目的目标使用群体主要为搜索引擎以及其他内容索引和分析工具。目前支持的文档格式和对应的解析类库如下:

文档格式

相应的解析类库

HTML

TagSoup

XML

自定义

微软的Office文档

Apache POI

OpenDocument format (ODF)

自定义

PDF

Apache PDFBox

EPUB

自定义

Rich Text Format (RTF)

自定义

压缩文件格式(如 ar, cpio, tar, zip, gzip, bzip2等)

Apache组织的Commons Compress

Txt

ICU

音频格式

主要采用Java的标准图像处理包javax.sound

图像格式

Java的标准图像处理包javax.imageio, 以及 metadata-extractor软件包。

视频格式

目前只支持Flash格式。

Java类文件

自定义

邮件mbox文件格式

自定义

文档格式

相应的解析类库

HTML

TagSoup

XML

自定义

微软的Office文档

Apache POI

OpenDocument format (ODF)

自定义

Apache PDFBox

EPUB

自定义

Rich Text Format (RTF)

自定义

压缩文件格式(如 ar, cpio, tar, zip, gzip, bzip2等)

Apache组织的Commons Compress

Txt

ICU

音频格式

主要采用Java的标准图像处理包javax.sound

图像格式

Java的标准图像处理包javax.imageio, 以及 metadata-extractor软件包。

视频格式

目前只支持Flash格式。

Java类文件

自定义

邮件mbox文件格式

自定义

Apache UIMA: Apache UIMA 是UIMA定义的Apache开源实现。UIMA是一个用于分析非结构化内容(比如文本、视频和音频)的组件架构和软件框架实现。这个框架的目的是为非结构化分析提供一个通用的平台,从而提供能够减少重复开发的可重用分析组件。 UIMA 架构允许您轻松插入定制的分析组件,并将它们与其他组件合并。您的 UIMA 应用程序不需要知道分析组件共同合作生成结果的细节。集成和组织多个分析组件是 UIMA 框架的工作。 UIMA 应用程序可能分析纯文本并识别人员、位置和组织;它也可能识别关系,比如为谁工作或在什么地方工作。应用程序通常可以拆分成组件。例如 “语言识别” => “特定于语言的部分” => “句子范围检测” => “实体检测(人员/位置的名称等等)”。

Apache Directory Studio: Apache Directory Studio是一个LDAP工具平台,支持连接到任何 LDAP服务器并进行管理和开发工作,但主要还是设计用于Apache Directory Server。功能包括:LDAP浏览器、LDIF编辑器、Schema编辑器、嵌入式 ApacheDS、ACI编辑器。